Bosszúpornón innen, átverésen túl: végérvényesen kinyílt a deepfake-szelence

Mi pedig egyáltalán nem vagyunk rá felkészülve

Még márciusban robbant a hír, miszerint Emma Watson deepfake áldozata lett: egy videóban bukkant fel a színésznő (arca), a kamera előtt látszólag épp szexuális aktusra készülvén. Aztán kiderült, hogy a videót megalkotó arccserélő-alkalmazás mögött álló cég célja – amely lehetővé teszi, hogy ugyanezt bármelyik arccal megtehessük egy tetszőleges videóban – épp a termék népszerűsítése volt. A sajtó beszámolója szerint a kampány részeként több mint kétszáz videót készítettek, ráadásul nemcsak Emma Watson képmásával, de például Scarlett Johanssonnal is. Miután azonban több millióan látták a videókat, azok egyszer csak eltűntek a Meta felületeiről – akárcsak az alkalmazás az Apple és a Google Play áruházakból. De ha azt gondolnánk, hogy ezzel meg is oldódott a helyzet, nagyobbat nem is tévedhetnénk… Mózes Zsófi írása.

–

Ha ugyanis rákeresünk, jó néhány más alkalmazás közül válogathatunk

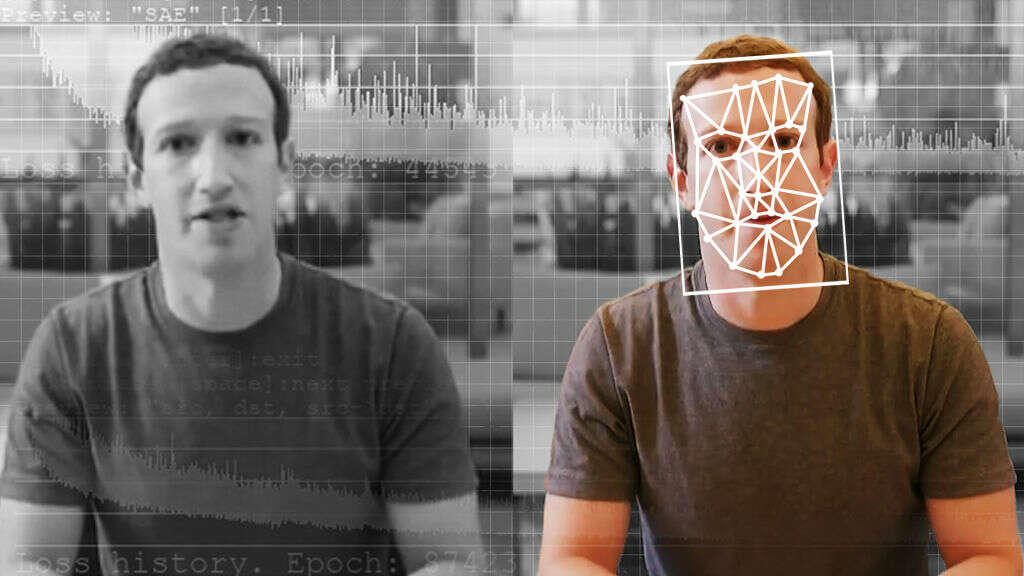

A deepfake-eket – olyan tartalmakat, amelyekben az arcokat vagy a hangokat kicserélik vagy manipulálják – az elmúlt években túlnyomórészt úgynevezett bosszúpornó készítésére használták, a technológia fejlődésével és elterjedésével azonban más területeken is elkezdték alkalmazni: nemcsak szexuálisan explicit videók létrehozására, hanem hamis információk terjesztésére, további megosztottság generálására, sőt akár átverésre is.

Így történt, hogy tavaly júniusban Karácsony Gergelyt felhívta videón keresztül valaki, aki Vitalij Klicsko kijevi főpolgármesternek adta ki magát – és akit csak a beszélgetés vége felé elhangzó gyanút keltő, már-már provokatív kérdések buktattak le. Karácsony azonnal tájékoztatta a kijevi főpolgármesteri hivatalt és a magyar titkosszolgálatot, az viszont egyszer s mindenkorra bizonyossá lett, hogy

a deepfake technológiája megkerülhetetlenné vált az interneten, ráadásul tényleg bárki az áldozatává válhat.

Néhány hónappal ezelőtt egy olyan videó keringett a neten, amelyben Kamala Harris amerikai alelnök azt mondta, hogy mindenki, aki a koronavírus miatt került kórházba, be volt oltva – az eredeti videóban azonban arról beszélt, hogy a betegek nem voltak beoltva. Nem sokkal ezután pedig egy olyan – szintén manipulált – videót, amelyen Joe Biden amerikai elnök nemzeti sorozásra szólította fel a népét az ukrajnai háború megvívása céljából, több nagy konzervatív Twitter-fiók is breaking newsként jelölte meg.

De nemcsak a magasan jegyzett személyek vannak veszélyben, ha a deepfake-ről van szó, hanem a leghétköznapibb emberek is. Mindez ráadásul csak a csúcsa annak a deepfake pornók alkotta jéghegynek, ami már évek óta kering az interneten.

Elmosódnak a valóság határvonalai

A legtöbb ember valószínűleg tisztában van azzal, hogy nem szabad mindent elhinni, amit látunk – ez pedig különösen igaz az internetre. Elvégre a világháló gyakorlatilag a kezdetek óta az álhírek és más típusú félretájékoztatások melegágya. És bár mára már az is viszonylag köztudott, hogy

a Photoshop és más képszerkesztői szoftverek rendkívül valóságosnak tűnő képeket tudnak készíteni olyan helyzetekről, amelyek soha nem történtek meg, a videók és hangfelvételek manipulációja azonban egy teljesen más – és merőben új – történet.

Ugyanis egészen a közelmúltig nem lehetett valakiről valósághű deepfake-videót vagy hangfelvételt készíteni bonyolult szoftverek és átlagon felüli számítástechnikai ismeretek nélkül. Sokáig például árulkodó jel volt, hogy a deepfake által generált videók résztvevői egész egyszerűen nem pislogtak. Manapság azonban számos eszköz áll rendelkezésre a hétköznapi fogyasztók számára is – akár okostelefonon futó alkalmazások formájában, és gyakran akár teljesen ingyen.

A deepfake-alkalmazások mellett, amelyekkel bármilyen arcot bármilyen testre rá lehet helyezni, van néhány hangklónozó eszköz, amelyeknek meg lehet tanítani, hogy meggyőzően szimulálják egy személy hangját, sőt olyan is, amelyik ezt hírességek hangjával is meg tudja tenni. Ezek pedig nemcsak könnyen hozzáférhetőek és olcsók, de olyan minőségű deepfake-eredményeket is produkálhatnak, amelyekkel sikeresen átverhetnek másokat.

Éppen ezért nem nehéz megjósolni, hogy mindezt hogyan használhatják fel fegyverként álhírek terjesztésére, konfliktusok gerjesztésére, politikai botrányok kirobbantására, közszereplők lejáratására vagy emberek zaklatására.

Ez bizonyos mértékben már meg is történt

A nem konszenzuson alapuló, hamisított szexvideókat például használták már nők elhallgattatására, megalázására és zaklatására. Volt áldozat, aki végül a névváltoztatás mellett döntött, más inkább törölte magát az internet minden felületéről, remélve: így elkerülheti, hogy ismét belefusson a róla készült álvideóba.

A közelmúltban több olyan csalás is történt, amely a deepfake hangmanipuláló technológiát alkalmazta: tavaly ez volt a leggyakrabban bejelentett csalásfajta az Egyesült Államokban, és ez okozta a második legnagyobb veszteséget a célpontok számára – összesen mintegy 11 millió dollárt.

És ha mindez nem lenne elég, a Graphika, egy New York-i székhelyű kiberkutató cég jelentése szerint a közelmúltban még egy olyan eset is előfordult, amikor a deepfake-technológiát egy kínai propagandának tűnő kampányban használták. Az általuk elemzett videók egyikében a Wolf News egyik műsorvezetője látszólag megtapsolja Kína geopolitikai kapcsolatokban betöltött szerepét egy nemzetközi csúcstalálkozón.

Csakhogy nincs olyan híradó, hogy Wolf News, a műsorvezető pedig nem is valódi személy – csak egy digitális bábu.

Van persze ennek jó oldala is: egy dél-koreai csatorna például egyik hírolvasójának a deepfake-verzióját ültette be a stúdióba híreket olvasni. A csatorna előre jelezte a nézőknek, hogy a képernyőn a mesterséges intelligenciával előállított hírolvasót látják majd, de egyúttal arról is beszámoltak, hogy a jövőben terveznek majd hasonló adásokat, amikor például váratlan események közvetítéséhez kell rendkívüli adást készíteniük.

Nem vagyunk felkészülve a digitális hamisítás következő hullámára

Elméletileg a legtöbb – ha nem is az összes – közösségi médiaplatform tiltja a deepfake-eket és a félrevezető módon manipulált tartalmakat. De éppúgy, ahogy egyelőre nem teljesen megbízhatóak a programok, amik a manipulált tartalmak felismerését ígérik, ezek a felületek sem kifejezetten jók a deepfake kiszűrésében. Az Emma Watsont ábrázoló hirdetés jó ideig a Meta platformjain maradt, mielőtt eltávolították volna, a korábban említett deepfake-videók közül pedig sokakat soha nem is távolítottak el.

Tekintve, hogy manapság milyen könnyű, olcsó és gyors a média manipulálása – és hogy ez a technológia milyen gyorsan fog fejlődni a következő néhány évben –, a legnagyobb technológiai cégeknek érdemes lenne fejleszteniük a tartalom moderálásával, a gyűlöletbeszéd és az álhírek visszaszorításával foglalkozó eszközeiket. Azonban az a helyzet, hogy az ágazatban a közelmúltban történt tömeges elbocsátásokból, illetve a mesterséges intelligencia elképesztő fejlődéséből ítélve úgy tűnik, a megoldás a deepfake-felismerő szoftverekben lesz.

Ezek viszont egyelőre elég alacsony hatékonysággal működnek, úgyhogy akár tetszik, akár nem, a deepfake-ektől nem szabadulunk meg ilyen könnyen.

Sőt, valószínűleg egyre valósághűbbek lesznek, ahogy a készítésükhöz használt mesterséges intelligencia technológiája is fejlődik, és bár jó alapszabálynak tűnik, hogy nem szabad mindent elhinni, amit látunk, a tudatos médiafogyasztással kapcsolatos tájékoztatás és általában az online világra vonatkozó szabályok ismerete, betartása és betartatása nélkül egyre nehezebb lesz felismerni, hogy mi igaz és mi nem.

Források: ITT, ITT, ITT, ITT és ITT

Kiemelt képünk illusztráció – Forrás: Getty Images/ The Washington Post / Contributor

WMN Aktív

WMN Aktív WMN Aktív

WMN Aktív